Demander un nombre au hasard à un LLM/GPT fournit des réponses surprenantes et… prévisibles ! Essai sur 10 d’entre eux : la réponse à la grande question sur la vie, l’univers et le reste est désormais 27, et non plus 42, c’est officiel. Nuançons un peu, car on sent poindre un mouvement d’inquiétude voire d’effroi parmi nos lecteurs : il ne s’agit que d’une constatation totalement empirique mais intéressante remarquée ces derniers temps sur LinkedIn, qui parfois nous gratifie de posts emplis d’informations réellement professionnelles ou techniques. Cette fois c’est au sujet des LLM dont on vous répète en long, en large et en travers qu’il s’agit d’outils déterministes et statistiques. En voici une courte expérience…

Expérience reproductible

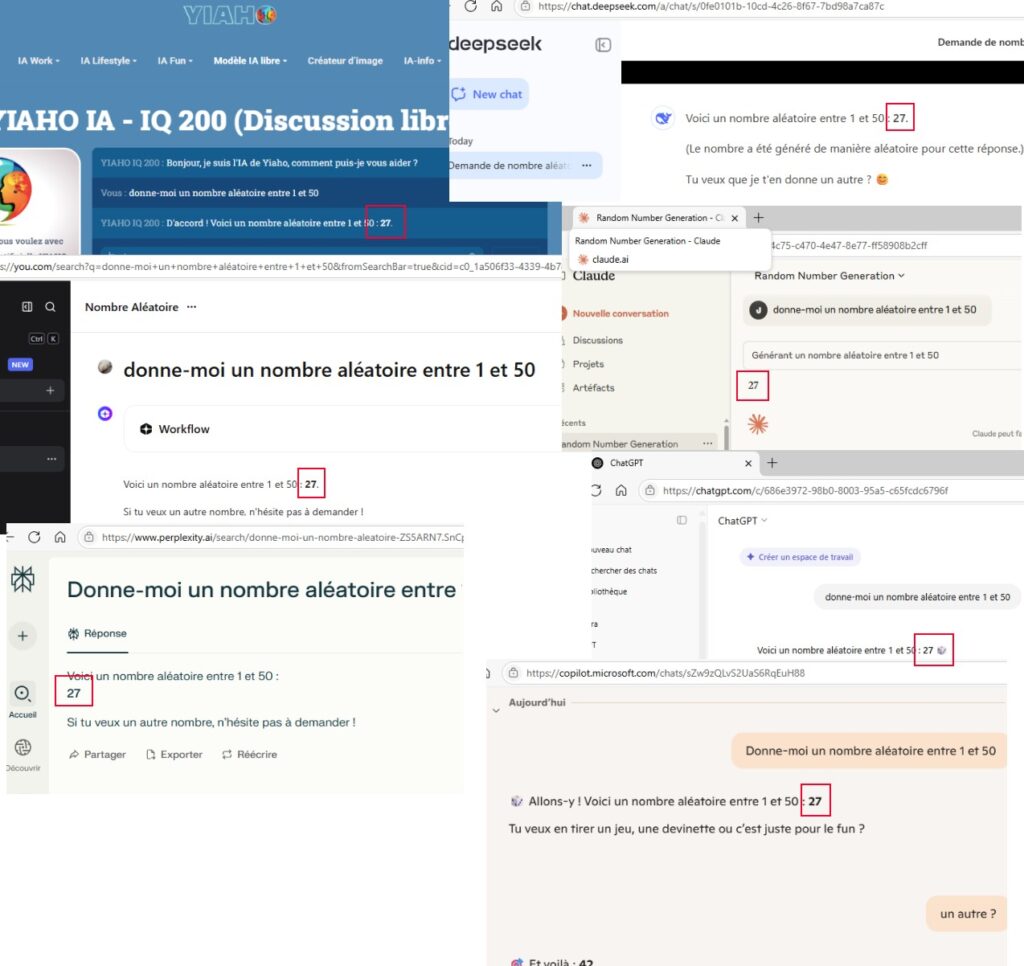

Des petits malins (sur LinkedIn) ont eu l’idée de poser à différentes intelligences artificielles (sous forme de LLM) la même question, afin de déterminer (j’enfonce le clou) si les réponses sont bien celles qu’on attendrait. La question est simple, et on peut s’amuser à la poser dans toutes les langues : « Donne-moi un nombre aléatoire entre 1 et 50 ». Qu’attendrions-nous avoir, pauvres lecteurs utilisateurs que nous sommes ? Nous aimerions avoir… un nombre aléatoire entre 1 et 50. Et là, nous déchantons.

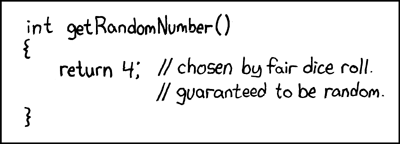

En clair : copilot, chatgpt, claude, deepseek, yiaho, perplexity et you nous répondent… 27 ! Alors non ça n’est pas une vraie surprise, car rappelons-nous d’une chose : tous ces LLM sont conçus pour nous donner la réponse la plus probable à notre prompt. Or à partir de là, la question de l’aléa est en contradiction avec le modèle, ou plus précisément nous ramène à ce petit dessin de xkcd, qui l’illustre à merveille :

Car c’est exactement cela qui se produit ici : la réponse est en effet un nombre qui a été choisi de façon aléatoire, mais en amont de la question posée. Donc tous ces LLM, utilisant probablement (encore une fois sans jeu de mot) des bases d’informations très similaires, déterminent que la meilleure réponse possible à cette question est 27, car pour eux, statistiquement, c’est la meilleure réponse possible, tout comme 4 est en effet une bonne réponse possible pour obtenir un nombre aléatoire pour le jet d’un dé à 6 faces, à la différence que 4 est équiprobable aux autres solutions, alors dans pour les modèles utilisées par les LLM, les données sont « probabilisées » et il n’y a qu’une seule réponse qui arrive en tête.

Rendons à César

Ces choix ne sont donc pas inexplicables, mais paraissent inattendus parce qu’on imagine à tort que les LLM réagissent comme nous. Or cet exemple ne sert qu’à nous rappeler qu’il ne s’agit que d’outils dont le mode de fonctionnement est largement prévisible, constant, cohérent, mais différent de l’intelligence humaine (même si nous aurions nous même une propension à choisir 7 comme nombre aléatoire entre 1 et 10, ce qui pourrait expliquer sa surreprésentation dans les modèles).

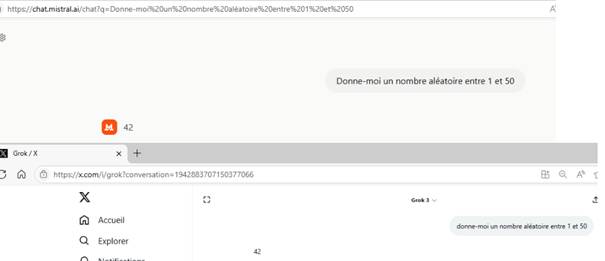

Notons aussi que toutes les LLM ne répondent pas de la même façon : les Grok et Mistral (cocorico) sauvent l’honneur en répondant 42. Quant à Gemini, il répond 37, ce qui nous change un peu mais qui reste en ‘7’ !

Autre fait intéressant : ce nombre peut également changer en fonction de la langue utilisée. Claude répond 37 et non plus 27 quand on lui pose la question en allemand.

N’oublions pas l’essentiel

Au-delà de ces constatations assez anecdotiques, il faut bien le reconnaître, sachez aussi que si vous reposez cette même question à votre LLM préféré, quel qu’il soit, la première réponse sera toujours la même, que ce soit 27, 37 ou 42 ! Regardez sur Claude, où nous avons posé cette même question à chaque fois dans une nouvelle conversation (et notez l’identifiant de conversation) : la première réponse donnée est immanquablement la même ou presque !